虽然人工智能(AI)模型变得越来越先进,但在传统计算机硬件上训练和运行这些模型非常耗能。因此,世界各地的工程师一直在尝试创建替代的、受大脑启发的硬件,以更好地支持人工智能系统的高计算负载。

Technion-IsraelInstituteofTechnology和PengChengLaboratory的研究人员最近创建了一个新的神经形态计算系统,支持深度信念神经网络(DBN),深度学习模型的生成和图形类。NatureElectronics中概述的该系统基于硅基忆阻器,这是一种既能存储又能处理信息的节能设备。

忆阻器是一种电子元件,可以切换或调节电路中的电流,同时还能记住通过它的电荷。由于它们的功能和结构比传统的记忆和处理单元更类似于人脑中的突触,因此它们可能更适合运行AI模型。

“作为一个大型科学界的一部分,我们已经研究神经形态计算已有一段时间了,”进行这项研究的研究人员之一ShaharKvatinsky告诉TechXplore。“通常,忆阻器用于执行模拟计算。众所周知,神经形态领域存在两个主要限制——一是忆阻技术仍未广泛应用。二是转换所需的转换器成本高模拟计算到数字数据,反之亦然。”

在开发他们的神经形态计算系统时,Kvatinsky和他的同事着手克服基于忆阻器的系统的这两个关键限制。由于忆阻器并未广泛使用,他们决定改用TowerSemiconductor开发的商用闪存技术,将其设计为像忆阻器一样工作。此外,他们专门用新设计的DBN测试了他们的系统,因为这种特殊模型不需要数据转换(即,它的输入和输出数据是二进制的,并且本质上是数字的。

“DBN是一个古老的机器学习理论概念,”Kvatinsky解释说。“我们的想法是使用二进制(即值为0或1)神经元(输入/输出)。有几个独特的属性(与深度神经网络相比),包括这种网络的训练依赖于计算累积的期望模型更新并仅在达到特定阈值时更新它。”

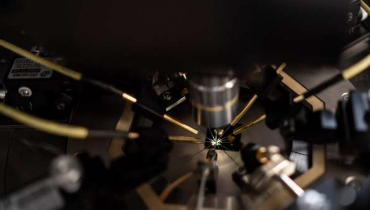

研究人员创建的人工突触是使用商业互补金属氧化物半导体(CMOS)工艺制造的。这些基于硅的忆阻突触具有许多优势特性,包括模拟可调性、高耐久性、长保留时间、可预测的循环退化以及跨不同设备的适度可变性。

Kvatinsky和他的同事通过在模式识别任务中训练一种称为受限玻尔兹曼机的DBN来演示他们的系统。为了训练这个模型(19x8忆阻器受限玻尔兹曼机),他们使用了两个12x8阵列的忆阻器。

“DBN的简单性使它们对硬件实施具有吸引力,”Kvatinsky说。“我们表明,即使DBN易于实现(由于它们的二进制性质),但在使用基于Y-Flash的忆阻器时,我们可以达到高精度(>97%的手写数字准确识别)。”

该研究团队引入的架构为运行受限玻尔兹曼机和其他DBN提供了一种新的可行解决方案。未来,它可能会激发类似神经形态系统的开发,共同帮助更高效地运行人工智能系统。

“我们现在计划扩大这种架构,探索更多的忆阻技术并探索更多的神经网络架构。”

东方时讯网

东方时讯网